将深度学习应用到医学影像中危及器官自动分割领域时,为解决训练样本不足时三维卷积神经网络优化出现的退化、梯度消失等问题,本研究将 Dense Net 与 V-Net 两个网络模型进行融合,开发一种用于三维计算机断层扫描(CT)图像自动分割的 Dense V-Network 算法,勾画女性盆腔危及器官。采用戴斯相似性系数(DSC)、豪斯多夫距离(HD)、杰卡德距离(JD)三个参数来定量评估分割效果。结果显示膀胱、小肠、直肠、股骨头和脊髓自动分割的 DSC 值均在 0.87 以上(平均值是 0.9);JD 值均在 2.3 以内(平均值是 0.18);除小肠外,HD 值均在 0.9 cm 以内(平均值是 0.62 cm)。经验证,Dense V-Network 网络可精准地勾画盆腔危及器官。

引用本文: 吴青南, 王运来, 全红, 王俊杰, 谷珊珊, 杨薇, 葛瑞刚, 刘杰, 鞠忠建. 基于有限训练样本的融合网络模型用于盆腔危及器官自动分割的研究. 生物医学工程学杂志, 2020, 37(2): 311-316. doi: 10.7507/1001-5515.201809011 复制

引言

为保证放射治疗实施的精确性和准确性,需要在患者计划计算机断层扫描(computed tomography,CT)图像上精准地勾画危及器官。然而勾画主要依赖于医生的经验和能力[1]。不同医生所勾画的危及器官往往存在差异,同一位医生在不同时期所勾画的危及器官也可能略有不同[2-3]。而且,勾画过程耗时较长,会延长患者的候治时间。因此,临床迫切需要一种自动分割危及器官的高效而精准的方法。

目前放疗工作中普遍使用基于图谱的分割方法(atlas-based segmentation,ABS)[4-7]。该方法将各个图谱用配准操作映射到待分割图像所在的图像空间中,得到两者之间的空间对应关系,图谱中的各组织器官的分割情况即待分割图像的分割结果。但该方法受患者体型、图谱库大小、CT 图像层数、配准精度等方面的限制,临床效果不佳[8]。尤其是盆腔器官,其大小形态、纹理灰度和相对位置受自然变异性、疾病状态、治疗干扰以及器官形变等影响而在不同个体间存在极大差异,导致临床可接受程度极低。

受深度学习在图像理解与分析领域取得的成功启发,许多研究者将其应用到放疗领域医学影像的处理中。目前,卷积神经网络(convolutional neural networks,CNN)用于二维图像分割已取得较为理想的结果[9],但用于三维图像分割仍存在诸多挑战。首先,三维医学图像的解剖环境比二维影像复杂得多,因此需要更多参数来捕获更具代表性的特征。其次,训练三维卷积神经网络经常面临各种优化困难,例如过度拟合、梯度消失或爆炸以及收敛速度缓慢等。第三,训练数据不足使得捕捉特征和训练深度三维卷积神经网络更加困难[10]。

研究发现,ResNet[11]、DenseNet[12]等将多种模型进行融合,较好地解决了在小训练样本的情况下,当梯度信息经过许多层时出现的梯度消失等问题。为了最大限度地挖掘学习能力,本研究尝试将 Dense Net 与 V-Net 两个网络结构模型进行融合,提出一种基于多模型融合的 Dense V-Network 算法,以实现快速且精准地勾画盆腔危及器官,并进行验证。

1 材料与方法

1.1 卷积神经网络结构

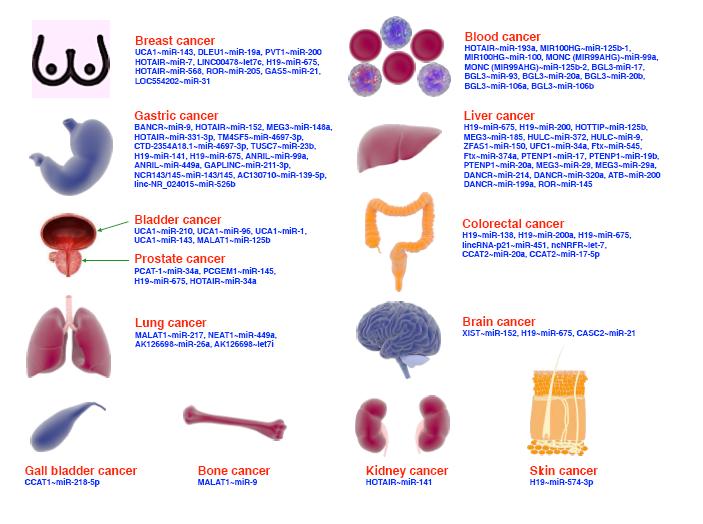

卷积神经网络利用卷积层来提取图像特征,通过加深网络层数可提取更抽象的特征值,目前在二维图像分割、图像识别等领域已经取得较理想效果。基于模型融合的 Dense V-Network 网络吸纳了 Dense Net 与 V-Net 两个图像分割模型的优点。如图 1a 所示,V-Net 网络采用三维卷积和深度残差网络组合[13],其中三维卷积有效提升了三维数据的感知,残差网络解决了增加深度导致训练误差增大的退化现象,加速了收敛。网络的左侧部分为压缩路径,以 2*2*2 卷积核进行池化。每个阶段包含一到四个卷积层,卷积层通过密接连接保证了信息流通并减小了训练参数。左侧早期阶段提取的特征传递到右侧部分,可以收集在压缩路径中丢失的微小细节,提高最终轮廓预测的质量。Dense Net 网络主要利用 Dense Block 结构[14]使每层从前面的所有层获得附加输入,并将其自身的特征映射传递到所有后续层,这种密集连接结构既解决了训练中出现的欠拟合现象,又因为特征图的重复利用,大大减少了模型中需要训练的参数量。如图 1b 所示,利用 3*3*3 的卷积核将上述两个网络融合在一起,融合后的 Dense V-Network 模型可实现上述两个网络结构的优势互补,既减少了需要调整的参数数目,降低冗余,节省训练所占内存空间,又减少了过度拟合现象。二者结合有效地解决了训练三维数据时出现的梯度消失或爆炸等问题,改善了收敛时间,使得在不增加训练集的前提下,通过单纯地增加网络深度来提高网络性能。

图1

网络结构

图1

网络结构

a. V-Net 网络;b. Dense V-Network 网络

Figure1. The structure of networka. V-Net; b. Dense V-Network

1.2 训练数据

本研究共采用解放军总医院 2018 年收治的 100 例分期相近的盆腔肿瘤患者数据。危及器官勾画均由主治及以上医师在 CT 影像上完成,再由资深主任医师进行修改并审核通过。

在卷积神经网络模型训练方面,随机选择了 80 例作为训练集,用于调整自动分割模型的参数,其余 20 例作为测试集,用于评估卷积神经网络模型的性能。为解决三维网络中训练样本不足的问题,本研究从每一例病例中随机抽取连续 64 层作为一个迁移样本,每个病例可以抽取 10~20 个样本,且对数据进行 10° 以内的随机旋转,最终总样本量达到 10 000,进一步达到数据增强的目的。

基于 ABS 分割方法,本研究使用自动化分割软件 MIM。在 MIM 中编写 Atlas 工作流,导入 80 例患者的 CT 和勾画数据,建立图谱库。另 20 例患者数据用于验证。

1.3 模型训练

为了尽可能减少训练时间,本研究先分别训练 V-Net 和 Dense Net 网络,使二者达到最优后冻结这两个部分,再对融合层进行微调,使其能达到最好的融合效果。训练流程如图 2 所示。本文提出的卷积神经网络算法基于 Keras 实现,在两块 NVDIA(GTX1080)图形显卡上进行运算。使用 Tensorflow 实现模型的训练、评估和错误分析,采用 cuDNN 计算内核进行编译。初始学习效率设为 0.000 5,学习速率衰减因子 0.5,衰减步长为 1 000,迭代次数设为 50 000 进行模型训练。

图2

网络结构训练流程图

Figure2.

The training flow chart of network structure

图2

网络结构训练流程图

Figure2.

The training flow chart of network structure

1.4 评价指标

使用戴斯相似性系数(Dice similarity coefficient,DSC)、豪斯多夫距离(Hausdorff distance,HD)、杰卡德距离(Jaccard distance,JD)三个参数定量评价自动分割的精度。

(1)DSC 为自动分割结果与医生手动分割结果的相似程度,用 A、B 表示两个轮廓区域所包含的点集,DSC 的计算公式见式(1):

|

其中|A∩B|代表 A 和 B 的交集。DSC 的数值范围是 0~1,数值越高分割效果越好。

(2)HD 反映两个轮廓点集之间的最大差异,计算公式见式(2):

|

其中,h(A,B)表示集合 A 中的点与集合 B 中点的距离最大值,即 h(A,B)=

,h(B,A)=

,h(B,A)=  。HD 值越小,意味着分割准确率越高。

。HD 值越小,意味着分割准确率越高。

(3)JD 值用于度量两个集合之间的差异性。JD 数值越大,样本相似度越低,其计算公式见式(3):

|

2 结果

2.1 Dense V-Network 算法分割精度定量评估

本研究所提出的模型融合算法自动分割精度量化评价的 DSC 值、HD 值和 JD 值结果的箱型图如图 3 所示,可以看出分割结果比较理想,但小肠的 HD 值较大。

图3

三个评估参数结果箱型图

Figure3.

The box plots of three evaluation parameter results

图3

三个评估参数结果箱型图

Figure3.

The box plots of three evaluation parameter results

表 1 中列出了膀胱、小肠、直肠、股骨头和脊髓三个量化参数的平均值。通常 DSC > 0.7 表示自动分割区域和手动分割区域两者重复度高,分割效果好[15]。从表 1 中看出 Dense V-Network 网络分割危及器官与医生手动勾画范围具有良好的重合性,DSC 均值为 0.90,HD 均值为 0.81 cm,JD 均值为 0.18。

图 4 展示了分割宫颈癌 CT 图像的分割效果,其中红色线条表示医生勾画的危及器官轮廓,蓝色区域为 Dense V-Network 算法自动分割结果。可以看出,本模型自动分割结果和医生手动勾画结果具有很好的一致性。

图4

CT 图像分割结果

Figure4.

The automatic segmentation result of CT image

图4

CT 图像分割结果

Figure4.

The automatic segmentation result of CT image

2.2 各个模型分割效果评价

为了评价融合模型的分割效果,研究将分别对 V-Net、Dense Net、Dense V-Network 三种结构进行训练和测试,并与 ABS 自动分割结果进行比较。采用评估自动和半自动分割方法准确性最常用的有效度量参数——DSC 值进行评价,V-Net、Dense Net 与 ABS 分割结果的 DSC 值见表 2。结合表 1 中 Dense V-Network 分割结果的 DSC 值,可以看出三种神经网络模型的自动分割结果均为良好,其中融合模型的各个器官 DSC 值结果均优于单一模型。而且,Dense V-Network 算法与常用的 ABS 方法相比,尤其是小肠和直肠结构,具有一定优越性。

3 讨论

危及器官的勾画差异会导致剂量的不确定性,从而影响治疗计划设计和剂量评估,最终可能导致治疗不安全、不可靠。现阶段放疗领域普遍采用 ABS 方法来提升勾画效率,但影响因素多、结果不够精确。基于多层监督学习的卷积神经网络具备较好的容错性、自适应性和权值共享等优点,训练好的模型操作简单、结果可靠,适合临床应用。但是已有的卷积神经网络在危及器官分割时存在一定的局限性,结果难以满足临床要求。故我们尝试将不同网络进行融合,以期提升效果。

本文提出一种基于多模型融合的放疗危及器官自动分割 Dense V-Network 算法,融合 Dense Net 和 V-Net 两种网络模型的优势,既可减少网络中所需要调整的参数量,缩短训练时间,又可解决网络深度增加所带来的退化问题,可通过增加网络深度来提高精度,增强了网络模型的可训练度。在三维训练样本有限时,本文方法可实现快速且精准地勾画危及器官。从结果看,除小肠 HD 值略大外,其余器官的 3 个评价指数均比较优秀,且勾画效果明显优于常用的 ABS 方法。经临床专家评估,一致认为本文方法勾画效果较好,操作快捷方便,优于现用软件。但小肠等结构仍需小范围修改。

关于基于深度学习进行盆腔危及器官分割的国际报道很少。二维深度卷积神经网络虽然取得理想效果,如 Kazemilar 等[16]利用 2D U-Net 直接学习 2D CT 灰度转换为相应的危及器官分割图像的特征映射,得到膀胱和直肠的 DSC 值分别为 0.95 和 0.92,优于本文结果。但该文献基于二维图像进行分割,不符合医学影像的三维特点,不能保证 CT 图像上下层间的信息交流,在实际应用中可能会造成一定的偏差。Balagopal 等[17]利用 3D U-Net 网络分割盆腔 CT 图像中的膀胱、直肠和左右股骨头,DSC 值分别为 0.95、0.84、0.96 和 0.95。膀胱的分割结果与本研究相同,本研究中直肠 DSC 值为 0.87,略优于其结果。Men 等[18]利用深度膨胀卷积神经网络(deep dilated convolutional neural network,DDCNN)自动分割膀胱、小肠、直肠、左右股骨头,DSC 值分别为 0.934、0.653、0.62、0.921 和 0.923,而本文所得结果,尤其是小肠和直肠,优于其结构。本研究利用融合模型 Dense V-network 算法分割盆腔危及器官,除小肠的 HD 值较大外,结果均优于绝大部分报道。

对于小肠结果较差,归纳为以下几点原因:① CT 边界不清,标注医生勾画困难,存在较大差异;② 部分医生将小肠和直肠勾画在一起;③ 部分数据未将整个小肠完整勾画,只对靠近靶区、需进行剂量评估的部分进行勾画;④ 因器官充盈程度而致肠道形态变化。⑤ 小肠体积较大,放大了偏差。上述原因也是导致其他软组织器官自动分割结果差的共同点,需要在后续研究中探索解决方法。

4 结论

本文融合 V-Net 和 Dense Net 的结构优点,开发 Dense V-network 模型用于盆腔部肿瘤患者 CT 图像危及器官的分割勾画。结果显示,在训练样本较小时,此模型可以精准地勾画膀胱、直肠、股骨头和脊髓等危及器官。通过 DSC 值定量评估,结果优于单一模型、ABS 分割方法和绝大部分国际报道,证明了多模型融合的优势。但若应用于放疗临床工作,仍需医生监督。随着算法结构的优化和训练数据的增加,预计结果可进一步改善。

利益冲突声明:本文全体作者均声明不存在利益冲突。

引言

为保证放射治疗实施的精确性和准确性,需要在患者计划计算机断层扫描(computed tomography,CT)图像上精准地勾画危及器官。然而勾画主要依赖于医生的经验和能力[1]。不同医生所勾画的危及器官往往存在差异,同一位医生在不同时期所勾画的危及器官也可能略有不同[2-3]。而且,勾画过程耗时较长,会延长患者的候治时间。因此,临床迫切需要一种自动分割危及器官的高效而精准的方法。

目前放疗工作中普遍使用基于图谱的分割方法(atlas-based segmentation,ABS)[4-7]。该方法将各个图谱用配准操作映射到待分割图像所在的图像空间中,得到两者之间的空间对应关系,图谱中的各组织器官的分割情况即待分割图像的分割结果。但该方法受患者体型、图谱库大小、CT 图像层数、配准精度等方面的限制,临床效果不佳[8]。尤其是盆腔器官,其大小形态、纹理灰度和相对位置受自然变异性、疾病状态、治疗干扰以及器官形变等影响而在不同个体间存在极大差异,导致临床可接受程度极低。

受深度学习在图像理解与分析领域取得的成功启发,许多研究者将其应用到放疗领域医学影像的处理中。目前,卷积神经网络(convolutional neural networks,CNN)用于二维图像分割已取得较为理想的结果[9],但用于三维图像分割仍存在诸多挑战。首先,三维医学图像的解剖环境比二维影像复杂得多,因此需要更多参数来捕获更具代表性的特征。其次,训练三维卷积神经网络经常面临各种优化困难,例如过度拟合、梯度消失或爆炸以及收敛速度缓慢等。第三,训练数据不足使得捕捉特征和训练深度三维卷积神经网络更加困难[10]。

研究发现,ResNet[11]、DenseNet[12]等将多种模型进行融合,较好地解决了在小训练样本的情况下,当梯度信息经过许多层时出现的梯度消失等问题。为了最大限度地挖掘学习能力,本研究尝试将 Dense Net 与 V-Net 两个网络结构模型进行融合,提出一种基于多模型融合的 Dense V-Network 算法,以实现快速且精准地勾画盆腔危及器官,并进行验证。

1 材料与方法

1.1 卷积神经网络结构

卷积神经网络利用卷积层来提取图像特征,通过加深网络层数可提取更抽象的特征值,目前在二维图像分割、图像识别等领域已经取得较理想效果。基于模型融合的 Dense V-Network 网络吸纳了 Dense Net 与 V-Net 两个图像分割模型的优点。如图 1a 所示,V-Net 网络采用三维卷积和深度残差网络组合[13],其中三维卷积有效提升了三维数据的感知,残差网络解决了增加深度导致训练误差增大的退化现象,加速了收敛。网络的左侧部分为压缩路径,以 2*2*2 卷积核进行池化。每个阶段包含一到四个卷积层,卷积层通过密接连接保证了信息流通并减小了训练参数。左侧早期阶段提取的特征传递到右侧部分,可以收集在压缩路径中丢失的微小细节,提高最终轮廓预测的质量。Dense Net 网络主要利用 Dense Block 结构[14]使每层从前面的所有层获得附加输入,并将其自身的特征映射传递到所有后续层,这种密集连接结构既解决了训练中出现的欠拟合现象,又因为特征图的重复利用,大大减少了模型中需要训练的参数量。如图 1b 所示,利用 3*3*3 的卷积核将上述两个网络融合在一起,融合后的 Dense V-Network 模型可实现上述两个网络结构的优势互补,既减少了需要调整的参数数目,降低冗余,节省训练所占内存空间,又减少了过度拟合现象。二者结合有效地解决了训练三维数据时出现的梯度消失或爆炸等问题,改善了收敛时间,使得在不增加训练集的前提下,通过单纯地增加网络深度来提高网络性能。

图1

网络结构

图1

网络结构

a. V-Net 网络;b. Dense V-Network 网络

Figure1. The structure of networka. V-Net; b. Dense V-Network

1.2 训练数据

本研究共采用解放军总医院 2018 年收治的 100 例分期相近的盆腔肿瘤患者数据。危及器官勾画均由主治及以上医师在 CT 影像上完成,再由资深主任医师进行修改并审核通过。

在卷积神经网络模型训练方面,随机选择了 80 例作为训练集,用于调整自动分割模型的参数,其余 20 例作为测试集,用于评估卷积神经网络模型的性能。为解决三维网络中训练样本不足的问题,本研究从每一例病例中随机抽取连续 64 层作为一个迁移样本,每个病例可以抽取 10~20 个样本,且对数据进行 10° 以内的随机旋转,最终总样本量达到 10 000,进一步达到数据增强的目的。

基于 ABS 分割方法,本研究使用自动化分割软件 MIM。在 MIM 中编写 Atlas 工作流,导入 80 例患者的 CT 和勾画数据,建立图谱库。另 20 例患者数据用于验证。

1.3 模型训练

为了尽可能减少训练时间,本研究先分别训练 V-Net 和 Dense Net 网络,使二者达到最优后冻结这两个部分,再对融合层进行微调,使其能达到最好的融合效果。训练流程如图 2 所示。本文提出的卷积神经网络算法基于 Keras 实现,在两块 NVDIA(GTX1080)图形显卡上进行运算。使用 Tensorflow 实现模型的训练、评估和错误分析,采用 cuDNN 计算内核进行编译。初始学习效率设为 0.000 5,学习速率衰减因子 0.5,衰减步长为 1 000,迭代次数设为 50 000 进行模型训练。

图2

网络结构训练流程图

Figure2.

The training flow chart of network structure

图2

网络结构训练流程图

Figure2.

The training flow chart of network structure

1.4 评价指标

使用戴斯相似性系数(Dice similarity coefficient,DSC)、豪斯多夫距离(Hausdorff distance,HD)、杰卡德距离(Jaccard distance,JD)三个参数定量评价自动分割的精度。

(1)DSC 为自动分割结果与医生手动分割结果的相似程度,用 A、B 表示两个轮廓区域所包含的点集,DSC 的计算公式见式(1):

|

其中|A∩B|代表 A 和 B 的交集。DSC 的数值范围是 0~1,数值越高分割效果越好。

(2)HD 反映两个轮廓点集之间的最大差异,计算公式见式(2):

|

其中,h(A,B)表示集合 A 中的点与集合 B 中点的距离最大值,即 h(A,B)=

,h(B,A)=

,h(B,A)=  。HD 值越小,意味着分割准确率越高。

。HD 值越小,意味着分割准确率越高。

(3)JD 值用于度量两个集合之间的差异性。JD 数值越大,样本相似度越低,其计算公式见式(3):

|

2 结果

2.1 Dense V-Network 算法分割精度定量评估

本研究所提出的模型融合算法自动分割精度量化评价的 DSC 值、HD 值和 JD 值结果的箱型图如图 3 所示,可以看出分割结果比较理想,但小肠的 HD 值较大。

图3

三个评估参数结果箱型图

Figure3.

The box plots of three evaluation parameter results

图3

三个评估参数结果箱型图

Figure3.

The box plots of three evaluation parameter results

表 1 中列出了膀胱、小肠、直肠、股骨头和脊髓三个量化参数的平均值。通常 DSC > 0.7 表示自动分割区域和手动分割区域两者重复度高,分割效果好[15]。从表 1 中看出 Dense V-Network 网络分割危及器官与医生手动勾画范围具有良好的重合性,DSC 均值为 0.90,HD 均值为 0.81 cm,JD 均值为 0.18。

图 4 展示了分割宫颈癌 CT 图像的分割效果,其中红色线条表示医生勾画的危及器官轮廓,蓝色区域为 Dense V-Network 算法自动分割结果。可以看出,本模型自动分割结果和医生手动勾画结果具有很好的一致性。

图4

CT 图像分割结果

Figure4.

The automatic segmentation result of CT image

图4

CT 图像分割结果

Figure4.

The automatic segmentation result of CT image

2.2 各个模型分割效果评价

为了评价融合模型的分割效果,研究将分别对 V-Net、Dense Net、Dense V-Network 三种结构进行训练和测试,并与 ABS 自动分割结果进行比较。采用评估自动和半自动分割方法准确性最常用的有效度量参数——DSC 值进行评价,V-Net、Dense Net 与 ABS 分割结果的 DSC 值见表 2。结合表 1 中 Dense V-Network 分割结果的 DSC 值,可以看出三种神经网络模型的自动分割结果均为良好,其中融合模型的各个器官 DSC 值结果均优于单一模型。而且,Dense V-Network 算法与常用的 ABS 方法相比,尤其是小肠和直肠结构,具有一定优越性。

3 讨论

危及器官的勾画差异会导致剂量的不确定性,从而影响治疗计划设计和剂量评估,最终可能导致治疗不安全、不可靠。现阶段放疗领域普遍采用 ABS 方法来提升勾画效率,但影响因素多、结果不够精确。基于多层监督学习的卷积神经网络具备较好的容错性、自适应性和权值共享等优点,训练好的模型操作简单、结果可靠,适合临床应用。但是已有的卷积神经网络在危及器官分割时存在一定的局限性,结果难以满足临床要求。故我们尝试将不同网络进行融合,以期提升效果。

本文提出一种基于多模型融合的放疗危及器官自动分割 Dense V-Network 算法,融合 Dense Net 和 V-Net 两种网络模型的优势,既可减少网络中所需要调整的参数量,缩短训练时间,又可解决网络深度增加所带来的退化问题,可通过增加网络深度来提高精度,增强了网络模型的可训练度。在三维训练样本有限时,本文方法可实现快速且精准地勾画危及器官。从结果看,除小肠 HD 值略大外,其余器官的 3 个评价指数均比较优秀,且勾画效果明显优于常用的 ABS 方法。经临床专家评估,一致认为本文方法勾画效果较好,操作快捷方便,优于现用软件。但小肠等结构仍需小范围修改。

关于基于深度学习进行盆腔危及器官分割的国际报道很少。二维深度卷积神经网络虽然取得理想效果,如 Kazemilar 等[16]利用 2D U-Net 直接学习 2D CT 灰度转换为相应的危及器官分割图像的特征映射,得到膀胱和直肠的 DSC 值分别为 0.95 和 0.92,优于本文结果。但该文献基于二维图像进行分割,不符合医学影像的三维特点,不能保证 CT 图像上下层间的信息交流,在实际应用中可能会造成一定的偏差。Balagopal 等[17]利用 3D U-Net 网络分割盆腔 CT 图像中的膀胱、直肠和左右股骨头,DSC 值分别为 0.95、0.84、0.96 和 0.95。膀胱的分割结果与本研究相同,本研究中直肠 DSC 值为 0.87,略优于其结果。Men 等[18]利用深度膨胀卷积神经网络(deep dilated convolutional neural network,DDCNN)自动分割膀胱、小肠、直肠、左右股骨头,DSC 值分别为 0.934、0.653、0.62、0.921 和 0.923,而本文所得结果,尤其是小肠和直肠,优于其结构。本研究利用融合模型 Dense V-network 算法分割盆腔危及器官,除小肠的 HD 值较大外,结果均优于绝大部分报道。

对于小肠结果较差,归纳为以下几点原因:① CT 边界不清,标注医生勾画困难,存在较大差异;② 部分医生将小肠和直肠勾画在一起;③ 部分数据未将整个小肠完整勾画,只对靠近靶区、需进行剂量评估的部分进行勾画;④ 因器官充盈程度而致肠道形态变化。⑤ 小肠体积较大,放大了偏差。上述原因也是导致其他软组织器官自动分割结果差的共同点,需要在后续研究中探索解决方法。

4 结论

本文融合 V-Net 和 Dense Net 的结构优点,开发 Dense V-network 模型用于盆腔部肿瘤患者 CT 图像危及器官的分割勾画。结果显示,在训练样本较小时,此模型可以精准地勾画膀胱、直肠、股骨头和脊髓等危及器官。通过 DSC 值定量评估,结果优于单一模型、ABS 分割方法和绝大部分国际报道,证明了多模型融合的优势。但若应用于放疗临床工作,仍需医生监督。随着算法结构的优化和训练数据的增加,预计结果可进一步改善。

利益冲突声明:本文全体作者均声明不存在利益冲突。